Sim

综合介绍

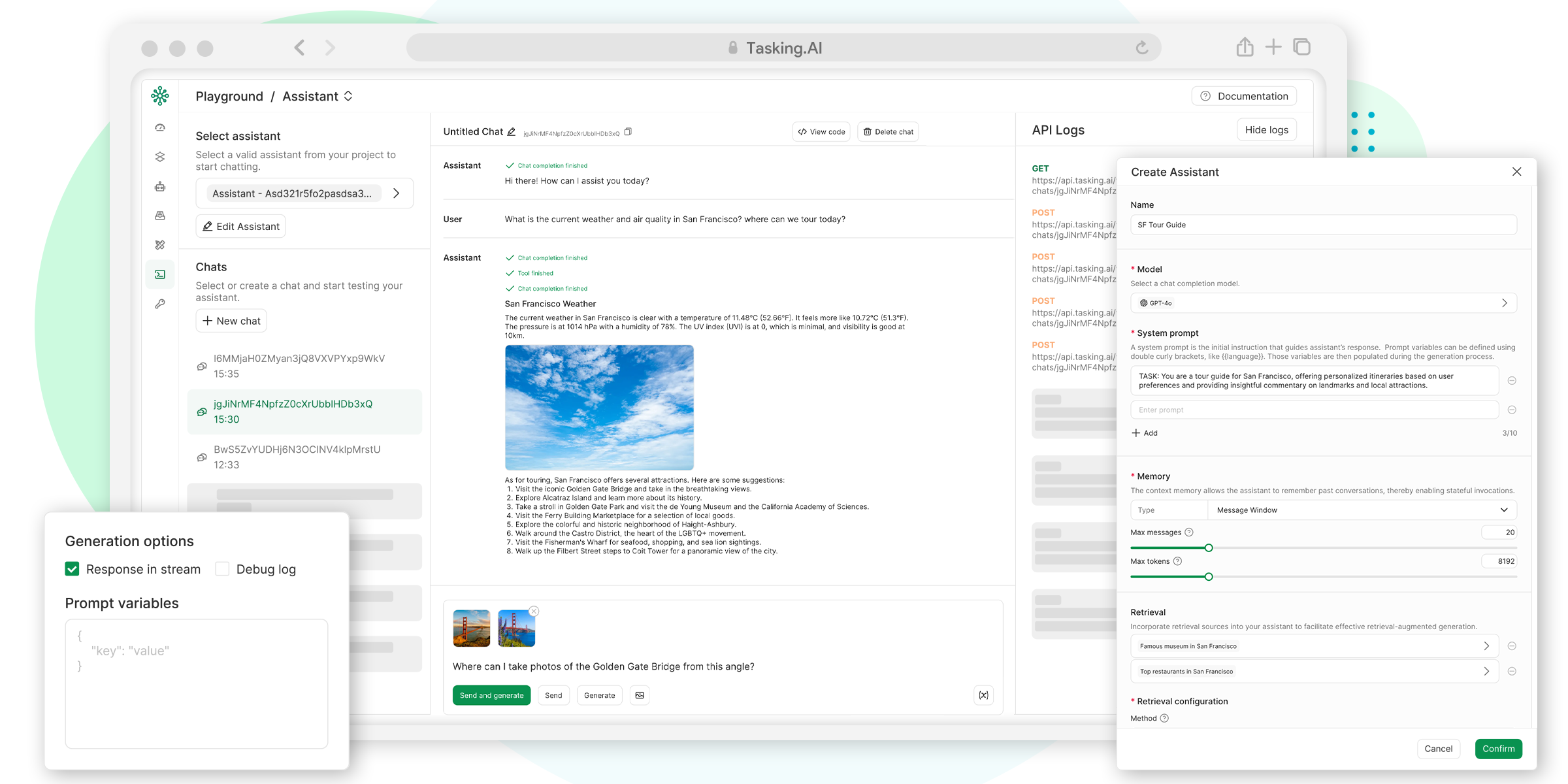

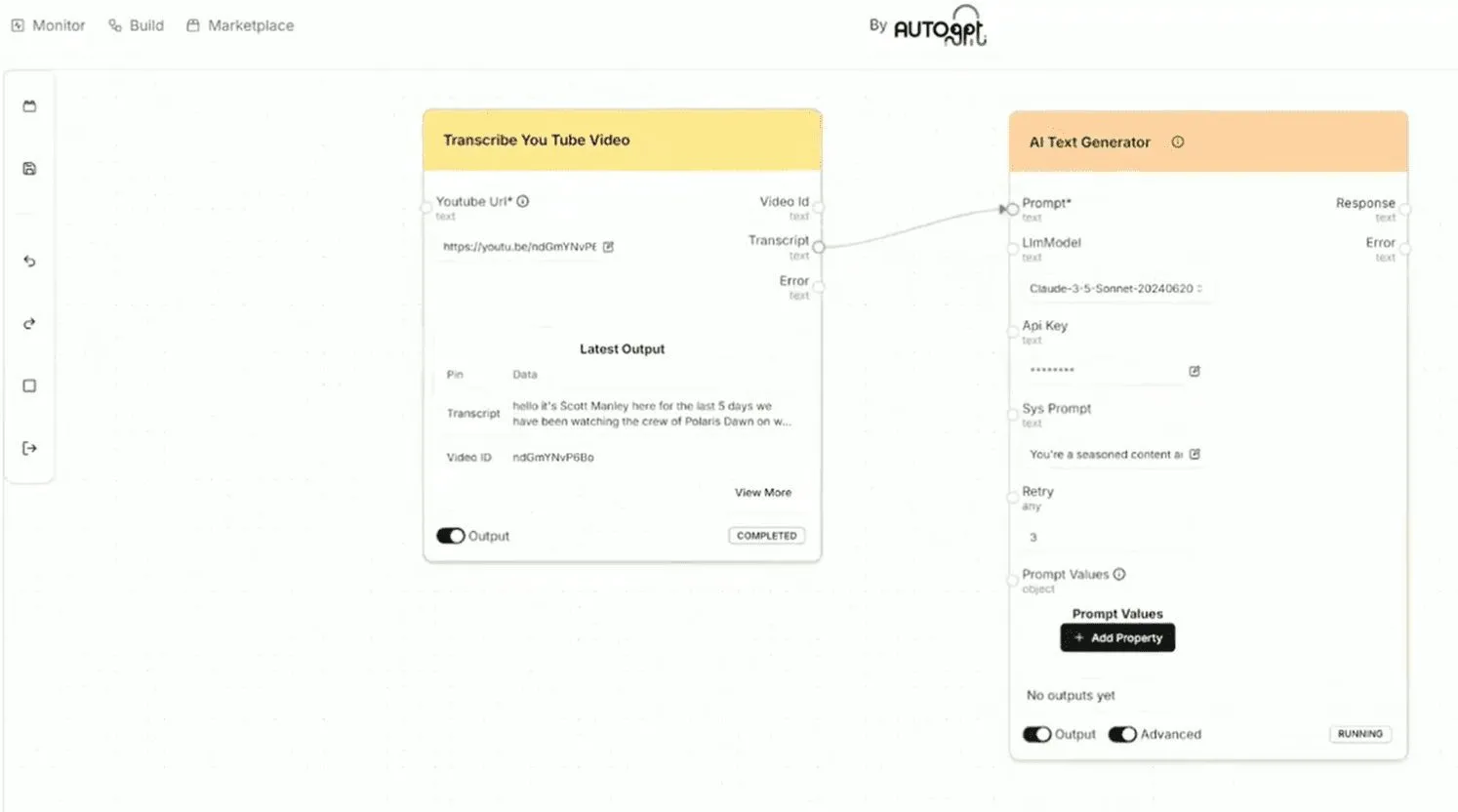

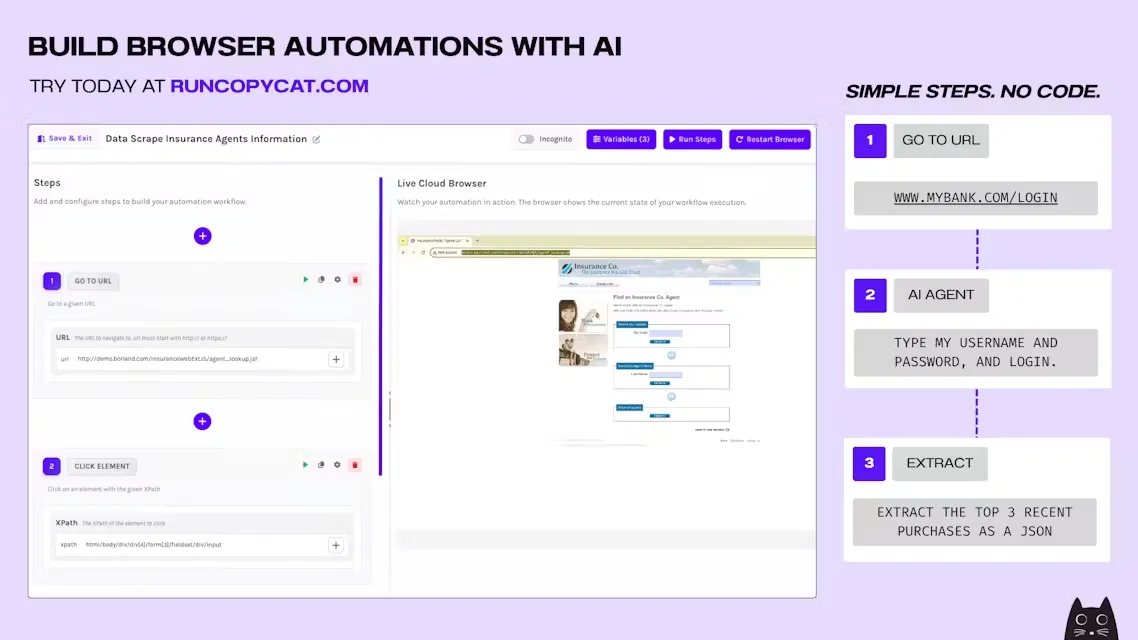

Sim 是一个开源的AI智能体工作流构建工具。 它提供了一个名为 Sim Studio 的轻量级、可视化界面,让用户能够快速构建和部署连接了各种工具的大语言模型(LLM)应用。 这个平台的特点是使用拖拽的方式来设计工作流,降低了构建AI应用的复杂性。 用户可以将不同的AI智能体和软件工具连接起来,就像绘制流程图一样直观。 Sim 支持多种大语言模型,例如 OpenAI、Anthropic 和 Google 的模型,同时也支持使用本地运行的 Ollama 模型。 该平台提供了超过100个集成工具,涵盖了像 GitHub、Gmail 和 Notion 这样的常见应用。 构建完成的工作流可以部署为API、聊天界面,或者按照预设时间自动运行。 Sim 的目标是简化企业创建和自动化处理各种业务流程。

功能列表

- 可视化工作流编辑器: 通过拖拽组件的方式,在画布上设计和构建AI智能体的工作流。

- 支持多种大语言模型: 支持并可以切换使用包括 OpenAI(GPT-4o, GPT-4, etc.)、Anthropic(Claude 3.7 Sonnet)、Google(Gemini 2.5 Pro, etc.)、Groq、Cerebras 以及本地运行的 Ollama 等多种模型。

- 广泛的工具集成: 可以连接超过100个外部服务和数据源,例如 Gmail、Slack、Pinecone 和 Supabase。

- 灵活的部署选项: 完成的工作流可以作为API或聊天界面发布,也可以设定在特定时间或间隔自动运行。

- 实时监控与日志: 提供详细的日志和性能指标,可以实时追踪工作流每一步的执行情况和成本。

- 版本控制: 内置版本管理功能,可以轻松追踪和管理工作流的变更,并根据需要回滚到之前的版本。

- 支持本地模型: 用户可以通过 Ollama 运行本地的AI模型,无需依赖外部API。

- 自定义代码: 允许开发者在工作流中插入自定义代码片段,以实现特殊功能。

- 团队协作: 支持团队成员在同一个项目上进行协作开发。

- 知识库与语义搜索: 利用向量嵌入技术,为AI智能体提供知识库和语义搜索功能,使其能够理解数据背后的语境和含义。

使用帮助

Sim 提供了云端托管版本和多种自托管选项,用户可以根据自己的需求选择合适的方式开始使用。

云端版本

最简单的方式是直接使用官方提供的云端版本,访问 www.sim.ai 即可开始体验。

自托管

对于希望在自己服务器上部署的用户,Sim 提供了多种自托管方案。无论选择哪种方式,都需要先在本地安装并运行 Docker。

选项 1: NPM 包(最简单)这是在本地运行Sim最便捷的方式。只需在终端中执行以下命令:

npx simstudio

运行后,在浏览器中打开 http://localhost:3000/ 即可访问。你也可以通过参数指定端口,例如 npx simstudio -p 4000。如果不想每次都拉取最新的 Docker 镜像,可以使用 --no-pull 参数。

选项 2: Docker Compose这种方式提供了更灵活的配置。

- 首先,克隆项目的代码仓库:

git clone https://github.com/simstudioai/sim.git - 进入项目目录:

cd sim - 使用

docker-compose.prod.yml文件启动服务:docker compose -f docker-compose.prod.yml up -d服务启动后,同样通过

http://localhost:3000/访问应用。

选项 3: 使用Ollama运行本地模型如果你希望使用本地的AI模型,可以结合Ollama进行部署。

- 对于有GPU的设备,运行以下命令,该命令会自动下载

gemma3:4b模型:docker compose -f docker-compose.ollama.yml --profile setup up -d - 对于只有CPU的设备:

docker compose -f docker-compose.ollama.yml --profile cpu --profile setup up -d等待模型下载完成后,即可访问

http://localhost:3000。如果需要添加更多模型,可以执行:docker compose -f docker-compose.ollama.yml exec ollama ollama pull llama3.1:8b

选项 4: 手动设置这种方式适合需要进行二次开发的开发者。环境要求:

- Bun 运行时环境

- PostgreSQL 12+ 并启用了

pgvector扩展

安装步骤:

- 克隆代码仓库并安装依赖:

git clone https://github.com/simstudioai/sim.git cd sim bun install - 设置带有

pgvector扩展的 PostgreSQL 数据库。推荐使用 Docker 启动一个数据库实例:docker run --name simstudio-db \ -e POSTGRES_PASSWORD=your_password \ -e POSTGRES_DB=simstudio \ -p 5432:5432 -d \ pgvector/pgvector:pg17 - 配置环境变量。进入

apps/sim目录,复制示例文件并修改:cd apps/sim cp .env.example .env在

.env文件中配置DATABASE_URL等必要变量:DATABASE_URL="postgresql://postgres:your_password@localhost:5432/simstudio" - 初始化数据库:

bunx drizzle-kit migrate - 启动开发服务器。推荐在项目根目录同时启动主应用和实时套接字服务器:

bun run dev:full或者,也可以在两个独立的终端中分别启动它们。

应用场景

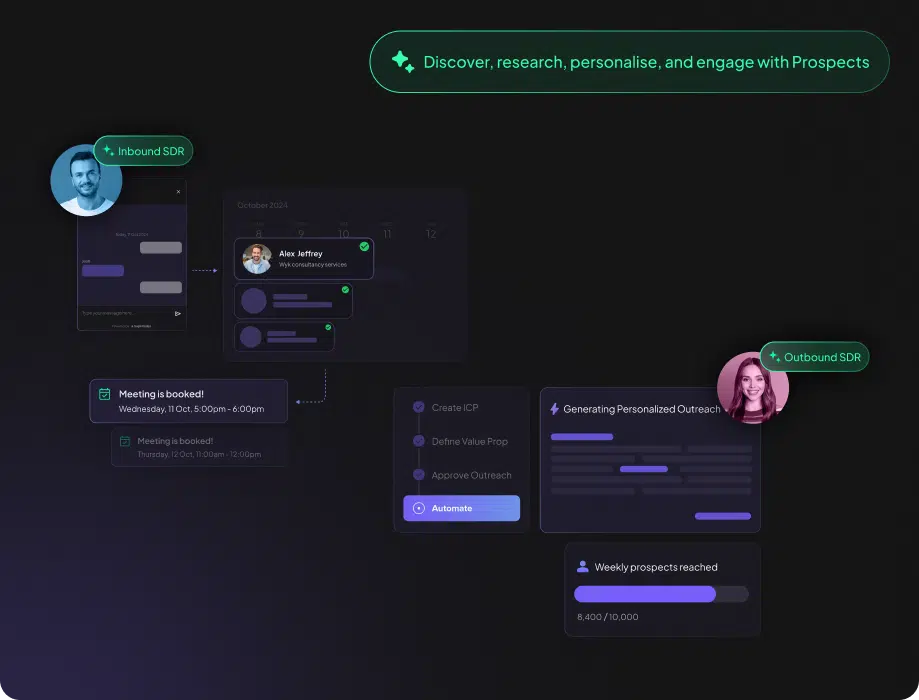

- 自动化客户支持可以构建一个AI智能体,连接到公司的知识库和工单系统。当用户通过网站聊天窗口提问时,智能体首先在知识库中搜索答案。如果找不到,它会自动创建一个工单,并将问题和用户信息填入工单系统,分配给相应的人工客服。

- 内容创作和分发创建一个工作流,首先调用AI模型生成一篇关于特定主题的文章。然后,将生成的文章通过API发送到公司的博客平台(如WordPress)自动发布。发布后,再调用社交媒体工具(如Twitter)的API,将文章链接和摘要自动分享出去。

- 数据分析和报告生成设计一个定时运行的智能体,每天凌晨自动从公司的数据库中提取前一天的销售数据。接着,它调用数据分析工具对数据进行处理和可视化,并使用AI模型根据图表生成一份简短的分析报告。最后,通过邮件或Slack将报告发送给管理团队。

- 个人任务助理用户可以为自己搭建一个个人助理。例如,设置一个通过邮件触发的工作流。当你收到一封包含会议请求的邮件时,智能体会自动解析邮件内容,提取会议时间、主题和参与人,然后在你的日历应用(如Google Calendar)中创建一个新的日程,并向相关人员发送邀请。

QA

- Sim Studio是完全免费的吗?Sim 是一个开源项目,基于 Apache-2.0 许可证,你可以免费地自行部署和使用。 同时,它也提供了云端托管服务,相关定价策略可以访问其官方网站

www.sim.ai获取。 - 我需要懂编程才能使用Sim吗?不需要。Sim Studio 的核心优势之一就是其可视化的拖拽界面,让没有编程背景的用户也能构建AI工作流。 当然,对于有特殊需求的开发者,平台也支持插入自定义代码。

- Sim支持哪些AI模型?Sim 支持多种主流的LLM供应商,包括 OpenAI、Anthropic、Google 等。此外,它还支持通过 Ollama 来运行本地部署的开源模型,让用户在数据隐私和成本方面有更多选择。

- 在Sim中创建的智能体可以和外部应用交互吗?可以。Sim 提供了超过100种工具集成,可以轻松连接到像Gmail、Slack、Notion、GitHub等常用软件和服务,让你的AI智能体能够执行发送邮件、更新文档、创建任务等多种操作。